以下都是copy来的。。。给自己一个思路.

POE.

以下COPY自POE.

人工智能(Artificial Intelligence,简称AI)、机器学习(Machine Learning,简称ML)、e-learning(电子学习)和神经网络(Neural Networks)在某种程度上是相关的概念。

人工智能是一门研究如何使计算机能够模拟人类智能的学科。它涵盖了各种技术和方法,旨在使计算机具备感知、理解、推理、学习和决策等智能行为。

机器学习是人工智能的一个子领域,关注如何设计和开发能够从数据中学习的算法和模型。机器学习的目标是使计算机能够根据数据和经验改进性能,而无需明确编程。通过机器学习,计算机可以自动分析数据、识别模式,并基于这些模式做出预测或做出决策。

神经网络是机器学习的一种方法,模拟了生物神经系统的结构和功能。它由大量的人工神经元组成,这些神经元通过连接形成复杂的网络。神经网络的训练过程基于数据的反馈和误差调整,通过调整神经元之间的连接权重,使网络能够自动学习和适应输入数据的模式。

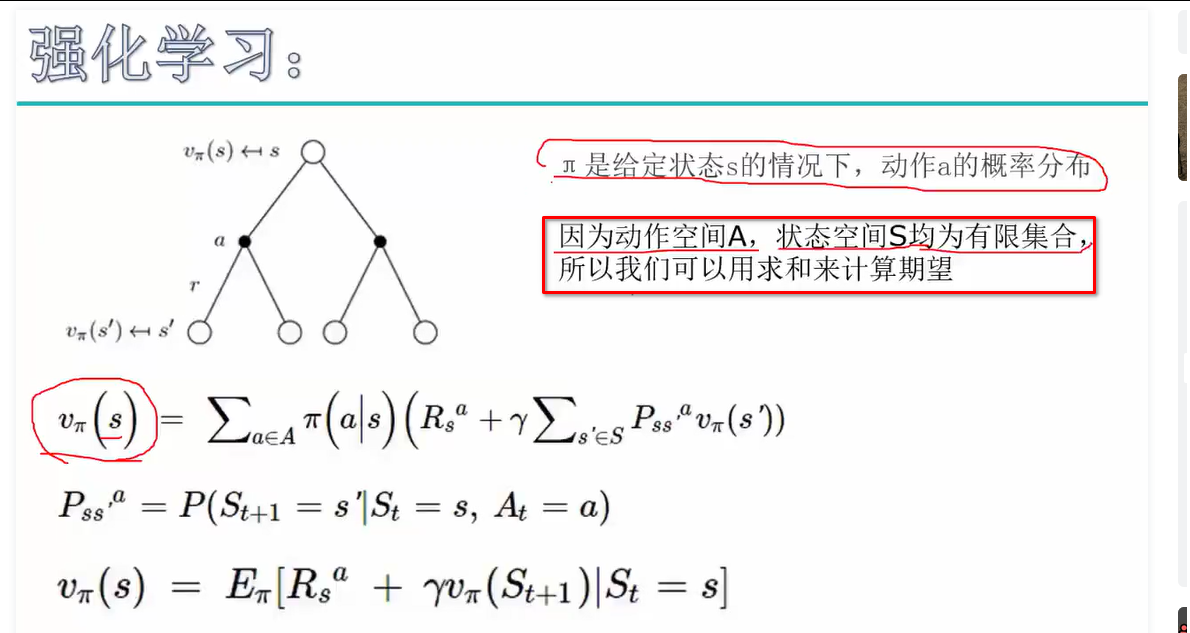

强化学习是机器学习的一个分支

总结来说,机器学习是人工智能的一个分支,而神经网络是机器学习中的一种方法。e-learning则是利用电子技术和互联网来进行教育和学习的方式,它可以借助人工智能和机器学习的技术来提供更个性化和智能化的学习体验。

强化学习(Reinforcement Learning)是机器学习的一个分支,但它也与人工智能(Artificial Intelligence)密切相关。

强化学习是一种学习范式,旨在使智能体通过与环境的交互来学习最优的行为策略。在强化学习中,智能体通过观察环境的状态和奖励信号,采取行动,并根据反馈信号对行动进行调整和优化。其目标是使智能体能够通过试错学习,从而最大化长期累积的奖励。

强化学习与人工智能的关系在于,它是实现人工智能的一种方法之一。人工智能的目标是使计算机能够模拟人类的智能行为,而强化学习是实现这一目标的一种方法。通过强化学习,智能体可以从与环境的交互中学习,逐渐改进其行为策略,并在面对不同情境和任务时做出智能决策。

强化学习在众多领域中有着广泛的应用,包括机器人控制、游戏智能、自动驾驶、资源管理、金融交易等。通过强化学习,智能体可以在不完全知识和不确定性的环境下学习和适应,并通过与环境的交互实现自主决策和智能行为。

马尔可夫(Markov)、Bellman和Q-learning是在强化学习(Reinforcement Learning)领域中使用的重要概念和算法。

强化学习是一种机器学习的分支,旨在让智能体通过与环境的交互来学习最优的行为策略。在强化学习中,智能体通过观察环境的状态和奖励信号,采取行动,并根据反馈信号对行动进行调整和优化。

以下是这些概念和算法的作用和用途:

马尔可夫(Markov):马尔可夫过程是强化学习中的基本概念之一。它是一种随机过程,具有马尔可夫性质,即未来状态的概率只与当前状态有关,而与过去的状态无关。马尔可夫过程提供了描述环境状态转移的数学框架。

Bellman方程:Bellman方程是强化学习中的关键方程,用于计算值函数(Value Function)。值函数表示智能体在某个状态下采取特定行动的长期累积回报期望值。Bellman方程通过递归地定义值函数,将当前状态的价值与下一个状态的价值联系起来,从而指导智能体学习最优策略。

Q-learning:Q-learning是一种基于值函数的强化学习算法,用于学习最优的行动策略。它通过维护一个动作值函数(Q函数),根据当前状态和奖励信号来更新动作值函数的估计值。Q-learning采用了一种基于贪心策略的方法,即在每个时间步中,智能体根据当前状态选择具有最高动作值的行动来进行学习和决策

马尔科夫: 当前的action, state 与收益率? 跟前一个后一个action无关

bellman: 有关

神经网络是人工智能领域中的一种重要技术和模型。它基于对生物神经系统的模拟,通过大量的人工神经元和它们之间的连接构建了一个复杂的计算网络。

神经网络的主要目标是通过学习和适应数据中的模式和关联性,从输入数据中提取有用的特征,并进行预测、分类、识别等任务。神经网络的学习过程通常采用反向传播算法,通过调整神经元之间的连接权重,使网络能够逐渐优化其输出结果。

神经网络的结构通常由三个基本层级组成:

输入层(Input Layer):接受外部输入或其他神经元输出的数据,并将其传递给下一层。

隐藏层(Hidden Layer):位于输入层和输出层之间的一层或多层。隐藏层中的神经元通过复杂的连接和权重来处理输入数据,并将其传递给下一层。

输出层(Output Layer):将隐藏层的输出转化为最终的结果,例如分类标签、预测值等。

神经网络的设计和配置可以根据具体任务的要求进行调整。常见的神经网络结构包括前馈神经网络(Feedforward Neural Network),卷积神经网络(Convolutional Neural Network),循环神经网络(Recurrent Neural Network)等。

训练AI打扑克(例如斗地主)可以使用以下一些AI中的概念和技术:

强化学习(Reinforcement Learning):强化学习是一种适用于训练AI进行决策和行动的技术。你可以使用强化学习来训练AI学习在不同情境下采取最优的扑克行动策略。通过定义合适的状态表示、行动空间和奖励函数,AI可以通过与环境的交互来学习并优化其策略。

马尔可夫决策过程(Markov Decision Process,MDP):马尔可夫决策过程是在强化学习中常用的建模框架之一。你可以将扑克游戏建模为一个MDP,其中状态表示当前的游戏状态,行动是AI的决策,奖励函数可以根据游戏胜负情况进行设计。通过定义合适的MDP,可以使用强化学习算法来训练AI学习最优的扑克策略。

深度强化学习(Deep Reinforcement Learning):深度强化学习结合了深度神经网络和强化学习的技术,可以用于处理高维、复杂的扑克游戏状态。通过使用深度神经网络作为值函数估计器或策略估计器,AI可以学习从原始的扑克牌状态中提取有用的特征,并进行决策和行动。

对手建模和对手策略:在扑克游戏中,对手的行为和策略对AI的决策有很大影响。你可以使用对手建模的技术来推测对手的策略和可能的行动,从而更好地制定AI的策略。这可以涉及到对对手的动作历史进行建模、推测对手的牌力或策略类型等方法。

数据生成和自我对弈:为了训练AI打扑克,你需要生成大量的数据来进行训练。一种常用的方法是使用自我对弈(self-play)的方式,让AI与自身进行对局,并记录下游戏状态、行动和胜负结果作为训练数据。通过反复迭代的自我对弈和学习过程,AI可以逐渐提升自己的扑克技能。

深度强化学习(Deep Reinforcement Learning)是将深度学习和强化学习相结合的一种方法,用于解决复杂、高维状态空间的强化学习问题。